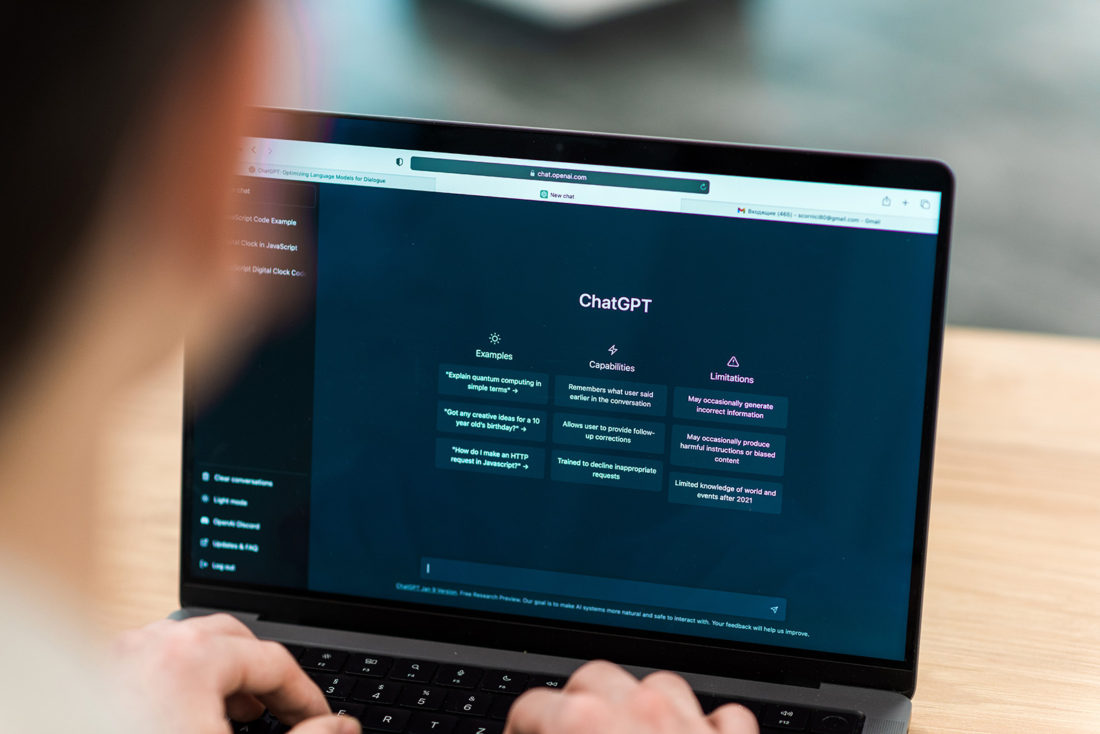

Sapevi che la verifica posizionamento sito su Google è uno dei primi passi da fare per la riuscita del tuo nuovo progetto?

L’ambizione di coloro che hanno un sito internet è essere primi nelle ricerche di Google. Un desiderio legittimo, visto il tempo dedicato, le risorse e il denaro speso per creare il tuo progetto.

Allora, quali cose devi fare per ottenere i primi posti su Google?

I motori di ricerca come Google e Bing sono le fonti principali per rendere visibile il tuo sito nel web.

Il sito in questione deve comparire nelle SERP di Google (la pagina dei risultati del motore di ricerca) per le keyword correlate al tuo business.

Molto spesso, ahinoi, alcuni siti internet non sono presenti su Google a causa di una mancata o sbagliata attività SEO, di conseguenza, facile a capirsi, non sono visibili sul web e non ottengono traffico.

Quali metodi puoi usare per fare la verifica posizionamento sito su Google?

- Ricerca manuale

- Tool di monitoraggio come SEMrush o Ubersuggest

- Google Search Consolle

Per ottenere un buon posizionamento, devi verificare il tuo punto di partenza, ovvero la condizione attuale del tuo sito, e metterlo a confronto con le linee guida che i motori di ricerca ci impongono. Cercheremo, in questo articolo, di descrivere brevemente quali sono e come possono aiutarti a raggiungere l’obiettivo.

Linee guida per il posizionamento sui motori di ricerca

Per far in modo che un sito internet sia ben posizionato nelle SERP di Google vi sono dei parametri da rispettare che si possono riassumere in:

- Ricerca di parole chiave attinenti e in linea con il proprio business;

- Fruibilità da PC, Tablet e Mobile;

- Il sito deve avere una buona usabilità;

- I contenuti devono essere di qualità;

- Deve essere veloce e avere un’ottima SEO OnPage e OffPage;

- Deve essere autorevole e rilevante per il settore di attinenza.

Se il tuo sito rispetta queste linee guida, quando effettui la verifica posizionamento sito su Google aumenterai tangibilmente le possibilità di trovarti al primo posto su Big G.

Utilizza i motori di ricerca come Google, Yahoo! e Bing

Per ottimizzare il sito web per i motori di ricerca, è necessario utilizzare i vari strumenti messi a disposizione da Google, come ad esempio, Google Analytics.

Questi strumenti permettono di scoprire dove si posiziona il proprio sito internet rispetto ai concorrenti.

Fare la verifica posizionamento sito su Google è una parte importantissima di ogni strategia SEO.

Se vogliamo ottenere maggiore visibilità sul web, questa procedura, naturalmente, è solo il primo passo di una complessa attività SEO.

Gli strumenti come Google Search Consolle e Google Analytics, consentono di analizzare il rendimento del sito quando le persone digitano determinate parole chiave nella barra di ricerca.

Il processo di aggiornamento dell’algoritmo di Google fa in modo che il posizionamento delle parole chiave sia in continuo cambiamento; per questo la verifica posizionamento sito su Google ha un ruolo importantissimo per il proprio sito web.

Verifica sito online

Il primo passo da compiere per verificare il posizionamento del sito su Google è quello di effettuare la ricerca manualmente, cioè cercare direttamente su Google la parola chiave lavorata di cui si è certi di essersi posizionati in prima pagina.

Per effettuare la verifica posizionamento sito su Google con questo metodo, la ricerca deve essere fatta rigorosamente in incognito, aprendo una nuova finestra del browser.

Questo eviterà di avere risultati falsati da visite pregresse a causa dei famosi cookie.

Inoltre se l’obiettivo del proprio sito è quello di posizionarsi per una ricerca locale, come ad esempio “dentista Roma”, non si può pretendere di comparire in una ricerca più generica e non geolocalizzata (non è detto che se si è posizionati in prima pagina con la chiave “dentista Roma” lo saremo anche per la chiave molto più generica “Dentista”).

Naturalmente bisogna analizzare i risultati di ricerca anche da mobile, perché potrebbero essere diversi dalle ricerche effettuate da desktop.

Il limite della verifica posizionamento sito su Google con il metodo della ricerca in incognito, è che quando si fa una ricerca per una determinata parola chiave, il risultato si basa solo su di essa, non tenendo in considerazione che il sito potrebbe essersi posizionato per altre keyword correlate e ricevere traffico da esse.

Esistono dei Tool o software che sono in grado di restituire il ranking completo del proprio progetto con tutte le parole chiave rilevanti comprese quelle non lavorate direttamente.

Tool di Google

Come accennato qualche riga fa, per il monitoraggio delle keyword e la verifica posizionamento sito su Google ci sono diversi tool.

Alcuni sono:

- Ubersuggest

- SEMrush

- MOZ

- Isearch from

- Whats My Serp

SEMrush, ad esempio, è utile per verificare il posizionamento del sito in lingue differenti. Questo tool permette di capire con quali keyword il sito è posizionato su Google.

Inoltre questo tool consente anche di analizzare i competitor: come agiscono e quali parole chiave utilizzano per posizionarsi tra le prime pagine di Google.

SEMrush permette anche di creare progetti e tenere traccia dell’andamento del proprio sito e quello dei nostri competitor.

Ubersuggest è un tool simile a SEMrush che consente di trovare centinaia di parole chiave che ruotano intorno a una determinata tematica.

Questo tool si concentra maggiormente sulle long tail o kewords a coda lunga, che hanno una capacità maggiore di convertire rispetto alle parole chiave secche.

Tramite Ubersuggest sarai in grado di capire cosa cercano gli utenti su internet e con quali termini di ricerca per trovare prodotti, informazioni e servizi.

Ranking sito web

Per analizzare il ranking del tuo sito web puoi utilizzare Google Search Consolle.

Nella sezione rendimento > Risultati di ricerca, si trovano le query che nel tempo hanno ottenuto più click, puoi vedere le impressioni, la posizione e capire quali pagine del sito hanno generato maggiore traffico.

Tramite questo tool gratuito di Google puoi ottenere molte più informazioni di quanto immagini.

Aggiungi contenuti rilevanti al tuo sito web

Per migliorare il posizionamento del sito web, è importante inserire contenuti pertinenti e rilevanti alle pagine web.

Fare questo aiuterà Google a capire di cosa parla il sito internet e di conseguenza lo inserirà nel motore di ricerca.

Tramite questo articolo abbiamo visto come effettuare una verifica posizionamento sito su Google e quali tool utilizzare.

Con questi suggerimenti potrai analizzare la tua strategia SEO e agire di conseguenza.

Informazioni sull’Autore

Sabrina Tocco

https://www.italywm.com/

Fonte: Article-Marketing.it