L’inquietante serie fantascientifica Black Mirror era in pausa dal 2019. L’ultima stagione, la sesta di Black Mirror, è uscita a giugno scorso. Se siete fan delle rappresentazioni distopiche del decadimento della società e dello squilibrio sociale provocato da una tecnologia che è inquietantemente vicina ad essere reale (o lo è già), potete rallegrarvi! Guarderò i nuovi episodi con voi e non mi sorprenderei se l’informatico Iyad Rahwan si unisse a noi.

Rahwan dirige il Centro per gli esseri umani e le macchine presso l’Istituto Max Planck per lo sviluppo umano, dove, secondo il suo sito web, si concentra sulla comprensione “dell’impatto delle macchine intelligenti sull’umanità”. Data la sua curiosità, sembra inevitabile che Rahwan si ispiri agli scenari fantasiosamente tetri che Black Mirror fa vivere. Ed è proprio così che è nato il suo nuovo lavoro, di cui è coautore insieme allo psicologo sociale Nils Köbis e altri. La ricerca esplora una versione più benigna della situazione che l’episodio di Black Mirror “Uomini contro il fuoco” drammatizza. Come descrivono Rahwan e i suoi colleghi, “i soldati percepiscono il mondo attraverso un filtro AI in tempo reale che trasforma i loro avversari in mostruosi mutanti per vincere la loro riluttanza a uccidere”.

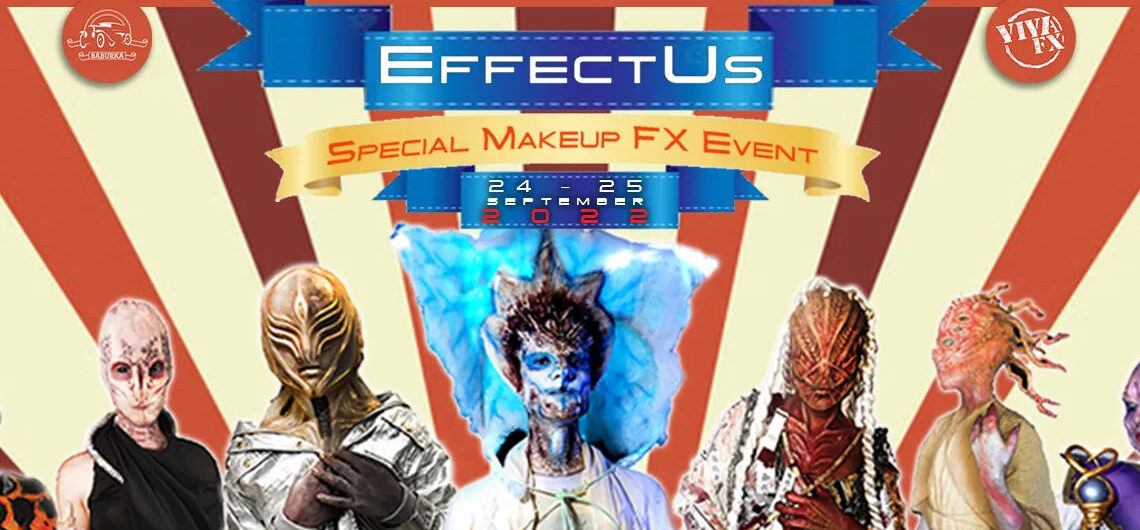

FILTRARE FUORI L’UMANITÀ: una clip tratta da Black Mirror che accenna a come i militari potrebbero alterare la percezione dei soldati utilizzando l’intelligenza artificiale per attenuare l’esitazione e il trauma associati allo sparare alle persone.

I ricercatori ritengono che l’episodio sia una meditazione sull’impatto che la tecnologia di offuscamento dei volti potrebbe avere su di noi dal punto di vista etico e psicologico. Molti di noi, sottolineano, sono già desensibilizzati all’uso di routine di sofisticati filtri che alterano le immagini su app come TikTok, dove gli utenti possono, ad esempio, assomigliare al loro io adolescente o, cosa più controversa, ritoccare il loro aspetto. “Quello di cui non ci rendiamo ancora pienamente conto è che i filtri potrebbero anche cambiare il modo in cui gli altri ci vedono. In futuro, le interazioni metaverse e le interazioni offline mediate da dispositivi di realtà aumentata offriranno infinite possibilità alle persone di modificare il modo in cui vedono il loro ambiente o il modo in cui vedono le altre persone”, scrivono. “In questo lavoro, ci siamo concentrati su una semplice alterazione, che è già facilmente implementabile in tempo reale: sfocare i volti degli altri”.

In tre esperimenti, Rahwan e i suoi colleghi hanno fatto giocare circa 200 persone a 10 round di due giochi online (nello specifico il Gioco del Dittatore e il Gioco della Carità). In ogni gioco, si può scegliere quanto denaro (2 dollari, con incrementi di 10 centesimi) regalare al proprio partner, che tiene il denaro offerto in uno dei round come ricompensa. Nel gioco del dittatore, il giocatore tiene quello che non regala; nel gioco della carità, il Programma alimentare mondiale tiene quello che non regala. In due esperimenti, i ricercatori hanno assegnato a caso ai partecipanti una foto di sé che il partner poteva vedere sfocata o non sfocata. Nel terzo esperimento, i soggetti hanno giocato mentre erano in videochiamata l’uno con l’altro, sempre con il volto sfocato o non sfocato.

Rahwan e i suoi colleghi affermano di aver riscontrato un effetto robusto: Le persone che giocavano con un partner offuscato nel Gioco del Dittatore assegnavano il denaro in modo più egoistico. “Questo risultato è in linea con l’idea che i filtri di sfocatura consentano il disimpegno morale spersonalizzando gli individui con cui interagiamo”, scrivono i ricercatori. Questo risultato supporta anche ricerche precedenti sul modo in cui le IA che interagiscono con gli esseri umani possono influenzare le decisioni morali. In uno studio del 2021, Köbis e Rahwan hanno scoperto che le IA potrebbero agire come “facilitatori di comportamenti non etici” che “possono permettere alle persone di trarre benefici non etici sentendosi bene con se stesse, un’interazione potenzialmente pericolosa”.

I risultati del gioco di beneficenza, tuttavia, sono stati contrastanti. Nell’esperimento video, le persone hanno dato più soldi ai loro partner sfocati che all’ente di beneficenza; nella versione non video, i soggetti hanno fatto il contrario, dando di più all’ente di beneficenza. Cosa succede? “L’interazione sociale con il partner è più pronunciata nel formato video grazie al carattere interattivo e simultaneo”, scrivono i ricercatori, “e potrebbe potenzialmente spiegare l’effetto capovolto”.

Su Twitter, Rahwan ha lasciato intendere che questo è solo l’inizio di una serie di esperimenti. “Questo lavoro fa parte dei nostri sforzi in corso per esplorare il concetto di ‘Science Fiction Science’ (o sci-fi-sci in breve)”, ha detto, “per simulare mondi futuri e poi testare le ipotesi sul comportamento umano in quei futuri”. Restate sintonizzati.

Aggiungi commento